Quantenfeldtheorie – was ist das?

Die Quantenfeldtheorie stellt eine Synthese der Speziellen Relativitätstheorie und der Quantentheorie dar – also der beiden großen Theorien, die am Anfang des 20. Jahrhunderts entstanden.

Die Spezielle Relativitätstheorie beschreibt Raum und Zeit, die Quantentheorie dagegen das Verhalten von subatomaren Teilchen. Als Physiker versuchten die beiden Theorien zu vereinen, traten unvermeidlich Lösungen mit negativen Energien auf. Es dauerte fünfzig Jahre, bis sie alle sich daraus ergebenden Konsequenzen konsistent interpretieren und alle scheinbaren Widersprüche und Paradoxa auflösen konnten.

Auch ohne in die mathematischen Details einzusteigen, lässt sich verstehen, warum das Problem der negativen Energien auftritt. Die wohl bekannteste Gleichung der Physik ist die Einsteinsche Beziehung zwischen der Energie und Masse eines Teilchens: Energie ist gleich Masse mal Quadrat der Lichtgeschwindigkeit. Doch diese einfache Beziehung gilt nur, solange sich das Teilchen in Ruhe befindet. Bewegt sich das Teilchen, so kommen weitere Terme hinzu. Problematisch dabei ist, dass die Energie nun quadratisch auftritt. Denn auch das Quadrat einer negativen Zahl ist positiv und aus diesem Grund hat die Gleichung stets zwei Lösungen – eine mit positiver Energie und eine mit negativer Energie. In der Speziellen Relativitätstheorie kann man einfach fordern, dass nur die positiven Lösungen gültig sind. In der Quantenmechanik geht dies jedoch nicht: Hier sind beide Lösungen gleichberechtigt und jeder Versuch, die eine Sorte zu verbieten, führt zu unlösbaren Widersprüchen.

Teilchen und Antiteilchen

Die Existenz von physikalischen Teilchen mit negativen Energien würde jedoch zu unsinnigen Folgen führen. So könnte ein Teilchen durch Abstrahlung von Energie, zum Beispiel in Form elektromagnetischer Strahlung, beliebig niedrige Energiewerte (anders formuliert: beliebig große negative Energiewerte) erreichen. Im Prinzip ließe sich auf diese Weise unbegrenzt viel Energie abstrahlen. Da wir so etwas jedoch in der Natur nicht beobachten, kann diese naive Interpretation der negativen Lösungen nicht richtig sein. Den Schlüssel zur korrekten Interpretation liefert die Beobachtung, dass man ein Teilchen mit negativer Energie als ein Antiteilchen mit positiver Energie interpretieren kann. Solche Antiteilchen sind gewissermaßen Spiegelbilder der „normalen“ Teilchen: Alle ihre physikalischen Eigenschaften wie Ladung, Drehsinn (“Spin“) und die abstrakteren Quantenzahlen sind genau entgegengesetzt, nur die Masse und damit die Energie sind identisch. Bei einigen wenigen Teilchen – wie etwa den Photonen – stimmen die Eigenschaften von Teilchen und Antiteilchen komplett überein. Hier sagt man, diese Teilchen seien ihre eigenen Antiteilchen.

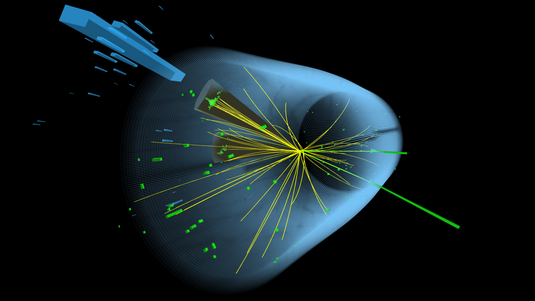

Aus der Tatsache, dass man zu jeder Lösung positiver Energie immer auch eine mit negativer Energie findet, folgt somit einfach die Aussage: Zu jedem Teilchen gibt es ein Antiteilchen. Und tatsächlich ist es Physikern gelungen, zu jedem existierenden Teilchen ein dazu gehöriges Antiteilchen aufzuspüren. Die Erhaltungssätze für Ladung und Quantenzahlen führen dabei dazu, dass in allen Experimenten stets nur Teilchen-Antiteilchen-Paare entstehen und verschwinden können.

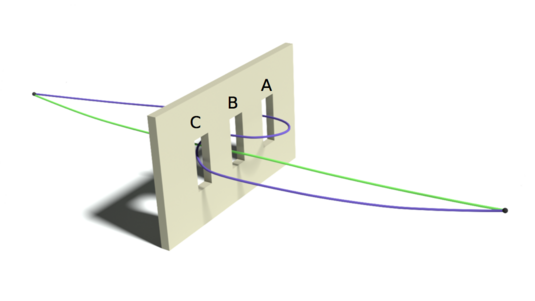

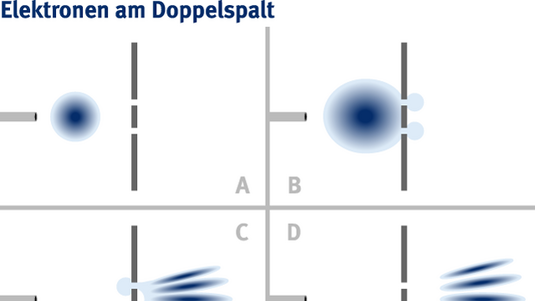

Die Symmetrie zwischen Teilchen und Antiteilchen ist nicht nur ein experimentelles Faktum, sondern auch ästhetisch ausgesprochen befriedigend. Allerdings führt diese Symmetrie in Kombination mit der Heisenbergschen Unschärferelation sofort auf das nächste grundlegende Problem. Die Unschärferelation erlaubt unter anderem eine Verletzung des Energieerhaltungssatzes, sofern die Dauer dieser Verletzung nur ausreichend kurz ist. Daraus aber folgt auch, dass jederzeit ein Teilchen und ein Antiteilchen aus dem Nichts entstehen können, sofern sich beide innerhalb der durch die Unschärferelation vorgegebenen Zeit wieder gegenseitig vernichten.

Virtuelle Teilchen

Wir können die Erzeugung virtueller Teilchen-Antiteilchen-Paare mit folgendem Vergleich illustrieren. Man denke an ein nächtliches Feuerwerk mit unterschiedlich großen Raketen, wobei jede explodierende Rakete umso kürzer leuchtet, je heller sie ist. Alle diese explodierenden Raketen erhellen gemeinsam den Nachthimmel, wobei jede Raketengröße gleich viel zur mittleren Helligkeit beiträgt. Gäbe es nun keine obere Grenze für die Größe der Raketen, so würde der Nachthimmel unendlich hell werden. Mathematisch spräche man dann von einer Divergenz der Flächenhelligkeit.

Wenn es keine obere Grenze für die Energie der virtuellen Teilchen-Antiteilchen-Paare gibt, findet man im Rahmen der Quantenfeldtheorie ganz analog zu diesem Beispiel, dass bei fast allen Rechnungen für beobachtbare Größen immer nur das sinnlose Ergebnis „unendlich“ herauskommt. Es muss also bei bisher unerforschten, sehr hohen Energien unbekannte physikalische Effekte geben, die diese Divergenzen verhindern. Nun könnten wir im Prinzip beliebige Spekulationen darüber anzustellen, wie die Gesetze der Physik in Energiebereichen aussehen, über die wir weder direkte noch indirekte Informationen haben. Aber offensichtlich wäre eine Theorie sinnlos, in der jede Vorhersage von Effekten im beobachtbaren Energiebereich von den unendlich vielen, nicht überprüfbaren Zusatzannahmen abhängt, die man dabei machen kann. Die einzige Lösung, um eine in sich geschlossene und aussagekräftige Theorie zu erhalten, besteht daher in der extrem einschränkenden Forderung: Nur solche Theorien sind zulässig, in denen die Physik bei niedrigen Energien unabhängig davon ist, in welcher Weise die Beiträge beliebig hoher Energie unterdrückt werden.

Im anschaulichen Bild unseres Feuerwerks würde dies bedeuten, dass die Häufigkeit extrem heller Raketen in irgendeiner Weise unterdrückt wird, dass wir aber unmöglich herausfinden können wie – zum Beispiel weil wir keine Messinstrumente besitzen, um ihre extrem hohe Leuchtkraft und ihre extrem kurze Leuchtzeit zu bestimmen. Wir finden also, dass der Nachthimmel nur eine endliche mittlere Helligkeit hat, aber wir können nicht angeben, wie sie genau zustande kommt.

Die oben formulierte Forderung lässt sich nur erfüllen, weil die Physik de facto zur Aufgabe hat, die Beziehungen zwischen den Ergebnissen verschiedener Experimente zu erklären. Um beispielsweise die Elementarladung zu bestimmen, kann man einerseits analysieren, wie ein Elektron niedriger Energie in einem Magnetfeld abgelenkt wird. Andererseits können wir messen, mit welcher Wahrscheinlichkeit bestimmte Teilchen erzeugt werden, wenn sich ein Elektron und ein Positron bei sehr hohen Energien vernichten. (Das war die Aufgabe des LEP-Beschleunigers am Forschungszentrum CERN.) Aus beiden Prozessen lässt sich nun die elektrische Ladung des Elektrons bestimmen. In der Schule lernt man, dass diese Elementarladung eine Naturkonstante sei.

Eichtheorien

Im Rahmen der Quantenfeldtheorie aber ist ihr effektiver Wert von den oben beschriebenen Quantenfluktuationen abhängig. Der Wert der Elementarladung hängt also vom benutzen Messprozess ab. Es reicht, wenn wir in der Lage sind, diesen Unterschied zu berechnen. So haben die drei Forscher David Gross, David Politzer und Frank Wilczek im Jahr 2004 den Nobelpreis erhalten, weil sie erfolgreich vorhergesagt hatten, wie der Wert der sogenannten „starken Kopplungskonstanten“ vom Messprozess abhängt. Bei ganz wenigen der unendlich vielen denkbaren Theorien sind nun die Unterschiede zwischen den effektiven Werten der Elementarladung in allen denkbaren Experimenten endlich. Nur solche Theorien liefern eine mathematisch konsistente Beschreibung der Welt.

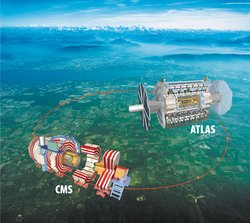

Tatsächlich hat sich gezeigt, dass nur die sogenannten Eichtheorien dieser Forderung genügen können. Die einfachste Form dieser Eichtheorien, die alle bekannten empirischen Tatsachen beschreiben kann, ist das sogenannte Standardmodell. Seit vielen Jahren sucht man – bisher ohne Erfolg – an allen großen Beschleunigerzentren der Welt nach einem Fall, in dem das Standardmodell eindeutig versagt. Denn ein solches Experiment würde einen ersten Blick auf die noch unbekannte Physik jenseits des Standardmodells erlauben. Momentan ruht die Hoffnung vor allem auf dem Large Hadron Collider am CERN, der 2007 seinen Betrieb aufnehmen soll.

Zum Abschluss sei noch das wohl bekannteste Beispiel für die Stärke der mathematischen Konsistenzforderungen in der Quantenfeldtheorie erwähnt: Im Standardmodell verschwinden alle Divergenzen nur dann, wenn die fundamentalen Materieteilchen, die sogenannten Fermionen, vollständige „Familien“ bilden, die jeweils aus einem Lepton (wie dem Elektron), einem Neutrino (wie dem Elektronneutrino) und zwei Quarks (wie dem Up- und dem Down-Quark) bestehen, wobei die Letzteren in jeweils drei Varianten („Farben“) vorkommen müssen. Tatsächlich bilden alle Fermionen, die man bisher gefunden hat, genau drei derartige vollständige Familien und es gibt starke Hinweise darauf, dass es keine weiteren Fermionen gibt.

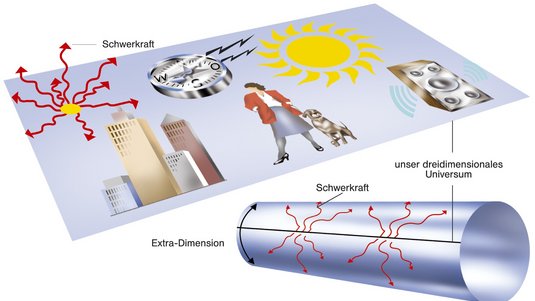

Die Tatsache, dass es die Quantenfeldtheorie erlaubt, aus rein mathematischen Konsistenzbedingungen derart konkrete Forderungen abzuleiten, die dann auch wirklich in der Welt realisiert sind, macht die ungeheure Faszination dieser Theorie aus. Auf die Spitze getrieben kann man hoffen, dass es letztlich nur eine einzige fundamentale Theorie gibt, die dann auch eine Quantentheorie der Gravitation enthalten sollte. Diese „Theory of Everything“ müsste zwar über die reine Quantenfeldtheorie hinausgehen, würde das Standardmodell aber als Grenzfall für niedrige Energien enthalten.

Quelle: https://www.weltderphysik.de/gebiet/teilchen/quanteneffekte/quantenfeldtheorie/