Neuromorphe Computersysteme

Maike Pollmann

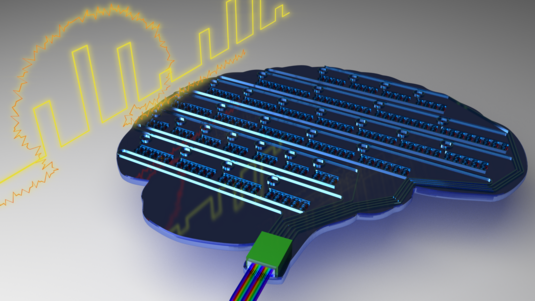

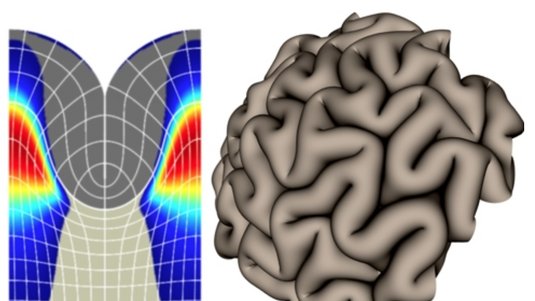

Das menschliche Gehirn dient Physikern als Vorbild, um neuartige Computerarchitekturen zu entwickeln. Welche Vorteile solche neuromorphen Systeme gegenüber klassischen Rechnern bieten und wie man sie herstellen will, erklärte Karlheinz Meier vom Kirchhoff-Institut für Physik der Universität Heidelberg in unserem Podcast. Hier finden Sie den Beitrag zum Nachlesen.

Das menschliche Gehirn besteht aus hundert Milliarden Nervenzellen, den Neuronen, die durch Billiarden synaptischer Verbindungen miteinander verknüpft sind. Diese Architektur scheint den menschgemachten Rechenmaschinen noch weit überlegen: Obwohl das Gehirn Unmengen an Informationen verarbeitet, liegt seine Leistungsaufnahme nur bei rund zwanzig Watt. Ein Laptop verlangt dagegen mindestens hundert Watt, Supercomputer mehrere Megawatt. Ein weiterer Vorteil des Gehirns liegt in seiner Fehlertoleranz.

Karlheinz Meier: „Wir wissen alle, dass wir Gehirnzellen verlieren – durch Alter, durch zu viel Alkohol, auch durch Krankheiten wie etwa kleine Schlaganfälle – und trotzdem ist unser Gehirn immer noch einsatzfähig. Das heißt, wir können durchaus zehn, zwanzig Prozent der Ressourcen verlieren und können immer noch das tun, was wir tun, um uns zu orientieren beispielsweise, zu lesen oder auch intellektuelle Leistung zu vollbringen.“

Das Gehirn hat also gelernt, mit fehlerhaften Komponenten zu arbeiten. Bei einem Mikroprozessor, der typischerweise aus hundert Millionen Transistoren besteht, kann bereits eine defekte Komponente das gesamte System lahmlegen. Zudem führen Computer lediglich Algorithmen – also eine Abfolge von feststehenden Kommandos – aus und können dementsprechend nur solche Probleme lösen, die der Programmierer in der Software auch vorgesehen hat.

„Beim Gehirn ist das offensichtlich nicht der Fall. Wenn Sie anhand mehrerer Beispiele gelernt haben, wie schnell ein Stein fällt und Sie kommen in eine Umgebung, in der Sie noch nie gewesen sind, und jetzt fällt kein Stein mehr, sondern vielleicht ein Schlüsselbund, dann sind Sie in der Lage, zu abstrahieren und die Physik des Fallens, die dazu gehört, aufgrund ihrer Erfahrung so zu verwenden, dass Sie zum Beispiel vorhersagen können, wann dieser fallende Schlüsselbund auf dem Boden auftrifft.“

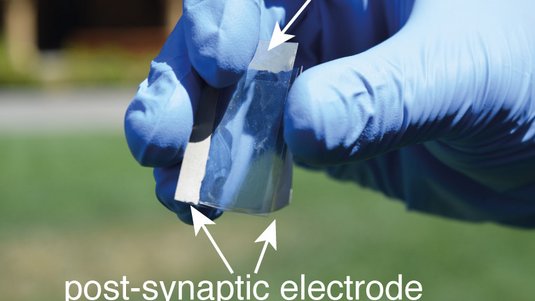

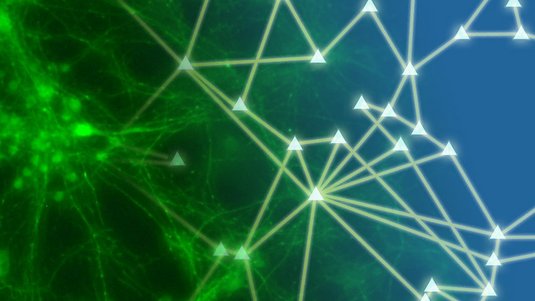

Wie das Gehirn Informationen derart erfolgreich verarbeitet, ist immer noch nicht im Detail verstanden. Man weiß, dass die Nervenzellen sowohl über elektrische Pulse als auch über chemische Signale miteinander kommunizieren. Die Information steckt etwa im chemischen Zustand der Synapsen – also den Kontaktstellen der Nervenzellen – oder der Aktivität der elektrischen Pulse, die in dem komplexen Netzwerk hin- und herlaufen. Seit vielen Jahrzehnten versuchen Wissenschaftler die Gehirnschaltkreise bereits in synthetischen Modellen nachzubilden. Ein erfolgreicher Versuch sind sogenannte neuronale Netze.

Neuronale Netze

„Bei diesen klassischen neuronalen Netzen steckt die Information in der Stärke der synaptischen Verbindung zwischen Nervenzellen. Das heißt, wenn ich nur lange genug herumdrehe, an dieser Stärke dieser synaptischen Verbindungen, dann kann ich Informationen speichern in dem System und ich kann auch auf ganz bestimmte Art und Weise Informationen verarbeiten, zum Beispiel für Texterkennung, Gesichtserkennung und solche Dinge.“

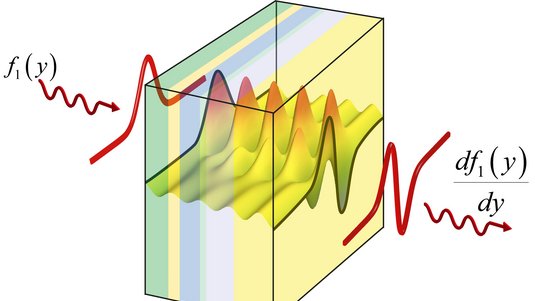

Für unser Kurzzeitgedächtnis scheint dieser Mechanismus allerdings ungeeignet, denn die chemischen Veränderungen in den Synapsen gehen vergleichsweise langsam vonstatten. Dabei ist ein Großteil der gigantischen Informationsmengen, die ständig in unser Gehirn strömen – wie etwa visuelle und akustische Reize, Signale von Muskeln und Knochen – nur für einige Hundert Mikrosekunden relevant. Danach sollen sie so schnell wie möglich wieder verschwinden. Eine alternative Theorie, wie diese Kurzzeitinformation gespeichert sein könnte, ist das „Liquid Computing“. Demnach steckt die Information in der Feueraktivität des Netzwerks. Die Membran der Nervenzellen fungiert dabei gewissermaßen als Kondensator, der die eingehenden elektrischen Pulse speichern kann. Einige Synapsen unterstützen diesen Aufladevorgang, während andere wieder Ladung abziehen. Überschreitet die Spannung der Membran schließlich einen gewissen Schwellwert, feuert das Neuron selbst einen elektrischen Puls ins Netzwerk – es sendet ein sogenanntes Aktionspotenzial aus.

„Die Information steckt also in diesem hochdimensionalen Netzwerk. Das ist so ähnlich, als würden Sie ein Stück Zucker in eine Kaffeetasse werfen. Dann sehen Sie ja Ringe, die sich ausbilden. Und wenn Sie eine Zeit lang warten, dann sind die Ringe immer noch da. Sie können also immer noch sagen: Vermutlich hat da vor gewisser Zeit jemand ein Stück Zucker reingeworfen. Wenn Sie aber noch länger warten, dann verschwinden die Ringe wieder, durch Reibungseffekte, durch Dissipation. Aber für eine gewisse Zeit hat diese Tasse gewissermaßen die Information in dem Aktivitätsmuster gespeichert und ein ähnliches Konzept – jetzt auf diese Aktionspotenziale bezogen – glaubt man, funktioniert auch im Gehirn.“

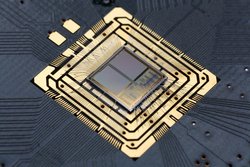

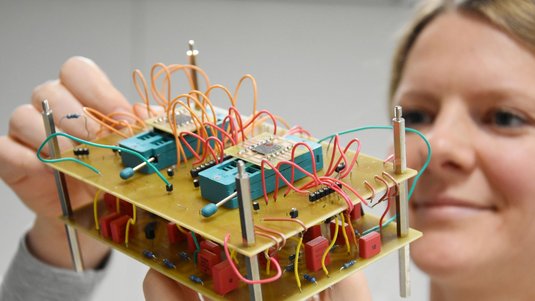

Karlheinz Meier und seine Kollegen bauen in ihrem Labor physikalische Modelle von neuronalen Schaltkreisen nach, nicht zuletzt um die verschiedenen Theorien zur Informationsspeicherung überprüfen zu können. Im einfachsten Modell imitieren elektrische Kondensatoren und Widerstände die Neuronen, während hinein- und hinausfließende Ströme als erregende und hemmende Synapsen agieren. Komplexere Modelle nutzen dagegen Zusammenschlüsse aus winzigen Transistoren, um die Nervenzellen und ihre Kontaktstellen nachzubilden.

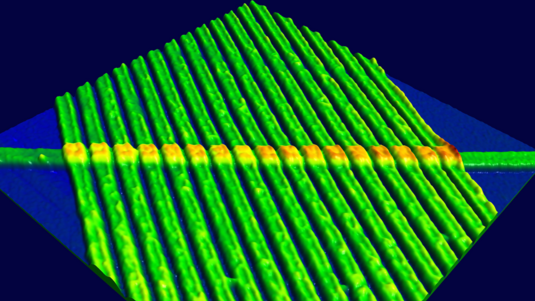

Nervenzelle aus dreihundert Transistoren

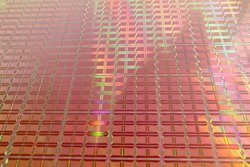

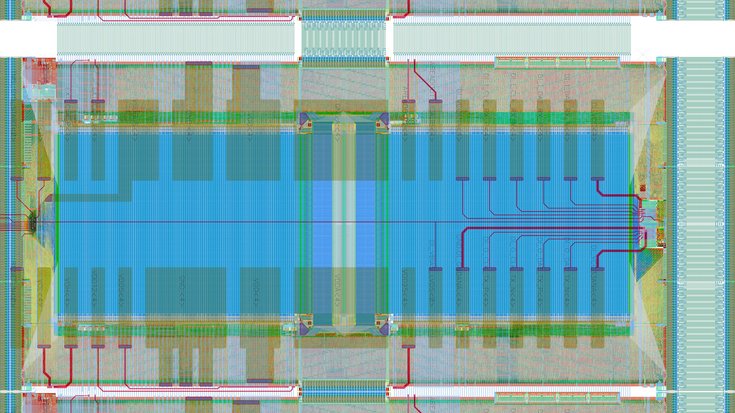

„Das hört sich zwar leicht an, ist in der Praxis aber schwierig durchzuführen, denn ich möchte ja sehr viele von diesen Systemen haben. Im Gehirn beispielsweise haben wir ungefähr 1011 solcher Neurone und 1015 Synapsen. Ich kann also nicht mehr die Bauteile aus meinem Kosmos-Baukasten verwenden, sondern brauche spezielle Substrate – Siliziumsubstrate –, auf denen ich das möglichst dicht umsetze. Genau das tun wir hier in Heidelberg: Wir verwenden heute Substrate auf ganzen Siliziumwafern, auf denen – um mal eine Zahl zu sagen – 200 000 Neurone und fünfzig Millionen lernfähige Synapsen als physikalisches Modell umgesetzt sind.“

Jede Nervenzelle besteht dabei aus dreihundert Transistoren, jede Synapse aus 25 dieser elektronischen Bauelemente. Damit der Schaltkreis auf der rund zwanzig Zentimeter großen Siliziumscheibe gewissermaßen zum Leben erwachen kann, müssen die Forscher erst die Verbindungen zwischen den Neuronen – also den Schaltplan – vorgeben. Zum Beispiel lassen sich alle Neuronen zufällig miteinander verknüpfen oder man kopiert eine Struktur aus der Biologie und konfiguriert das System je nach dem gewünschten Experiment.

„Die von uns gebauten Systeme sind also nicht vorbestimmt in ihrer Funktionalität: Sie können Experimente mit dem Hörsystem von Eulen durchführen, mit dem Geruchssystem von Insekten, Sie können auch völlig abstrakte Experimente machen – wie zum Beispiel dieses ‚Liquid Computing‘, das ich vorher beschrieben habe. Sie können dann beispielsweise versuchen, ganz simple Effekte darzustellen, wie etwa die Wellenausbreitung in solchen Systemen, die man beobachten kann. All das ist der Fantasie der Benutzer überlassen. Es ist eine Experimentalplattform, auf der man das ausprobieren kann.“

Diese sogenannten neuromorphen Systeme lassen sich nun ebenso anregen wie biologische Systeme, doch im Gegensatz dazu können die Forscher in den nachgebauten Systemen gezielt bestimmte Parameter verändern und die resultierenden Aktivitätsmuster auslesen. In den Schaltkreisen lässt sich beispielsweise die Stärke beeinflussen, mit der Synapsen Informationen übertragen, aber auch die Neuronen selbst: etwa ihre Feuerschwelle oder die Wartezeit, bis der nächste Puls eintreffen kann.

„Und schlussendlich gibt es noch einen anderen Parameter, der sich nicht so leicht handhaben lässt, der aber auch wichtig ist: die Art der Vernetzung. Sie müssen ja wissen, welches Neuron mit welchem verbunden ist. Und wir wissen, dass sich in unserem eigenen Leben während des Entwicklungsprozesses – gerade in der frühen Kindheit – diese Vernetzungen ändern. Im Gegensatz zum Lernen ist das der Entwicklungsprozess. Und auch so etwas können Sie im Prinzip auf unserem System nachbilden. Sie können also diese Schalter, die diese Neurone miteinander verbinden, umlegen und auf diese Weise Entwicklungsprozesse emulieren. Aber so weit sind wir momentan noch nicht in praktischen Experimenten.“

Human Brain Project

Lernprozesse dauern einige Stunden oder Tage, Entwicklungsprozesse mehrere Jahre. Diese Vorgänge im Computer nachzuspielen, ist nahezu unmöglich – denn konventionelle Simulationen laufen selbst auf Hochleistungsrechnern typischerweise hundert bis tausendfach langsamer als in der Biologie. Der Zeitaufwand wäre also schlicht zu hoch. Die physikalischen Modelle reagieren viel schneller – momentan 10 000-mal schneller als die Biologie.

„Das heißt, wenn wir einen Tag anschauen wollen – emulieren wollen, wie wir sagen – dann brauchen wir nicht hundert Tage, sondern nur zehn Sekunden. Und so ein Experiment kann man natürlich auch hundertmal wiederholen. Das ist gar kein Problem. Das ist eine ganz wichtige Sache. Ich glaube, dass diese neuromorphen Systeme, diese physikalischen Modelle mit den beschleunigten Zeitkonstanten, die einzige Möglichkeit sind, diese zeitabhängigen Prozesse wirklich zu untersuchen.“

In den vergangenen zehn Jahren haben Meier und seine Kollegen in zwei Forschungsprojekten bereits die Grundlage für die neuromorphen Systeme gelegt. In den kommenden Jahren wollen sie die neuartige Computerarchitektur im Rahmen des Human Brain Projects weiterentwickeln. Das Ziel dieses Großvorhabens, an dem gut 250 Wissenschaftler aus 23 Ländern mitwirken, ist es, neue medizinische und neurowissenschaftliche Einblicke in das Gehirn und seine Erkrankungen zu erhalten, aber auch innovative Computer- und Robotiktechniken zu entwickeln. Zunächst will man dafür alle verfügbaren Daten über das menschliche Gehirn sammeln und schließlich dessen Funktionsweise und Struktur detailgetreu in einer Computersimulation nachbilden.

„Dann wollen wir diese Computersimulationen – die auf konventionellen Hochleistungscomputer gemacht werden – benutzen, um vereinfachte Modelle zu erstellen. Dabei setzen wir im Wesentlichen die wichtigen Abstraktionen in ein physikalisches Modell um, also in das, was auch als ‚neuromorphic Computing‘ bezeichnet wird. Auf diese Weise wollen wir synthetische Systeme bauen, die hoffentlich ähnliche Vorteile haben wie unser Gehirn. “

Eine zweieinhalbjährige Startphase hat im Oktober 2013 begonnen. Anwenden ließen sich die neuromorphen Systeme auch außerhalb der Biologie. Eine Utopie wären beispielsweise neuartige Wettervorhersagen. Heutzutage überwachen Meteorologen das Wetter rund um den Globus und können mithilfe von Klimamodellen, in denen unser Wissen über die zugrunde liegende Physik steckt, das Wetter für den kommenden Tag recht genau vorhersagen. Nun könnte man die Wetterdaten für eine bestimmte Region auf der Welt auch in den neuromorphen Rechner einspeisen.

„Und wenn wir das schaffen, dann hieße das, dass das System gelernt hat, die Regeln des Wetters – und das sind am Ende die Regeln der Physik – zu lernen. Und zwar ohne, dass wir dem System vorher Physik beigebracht hätten. Das Ding weiß nichts von Thermodynamik und von Strömungsgesetzen – Bernoulli und ähnlichen Dingen –, sondern das muss es selbst lernen aufgrund der Daten, die es vorher gesehen hat. Und wenn einem das an einem System wie dem Wetter gelingt – vielleicht nicht gerade über viele Tage, aber wenn auch nur für einige Stunden, das wäre ja schon ganz toll – dann glaube ich, gibt es eine Menge Anwendungen in unserer Welt. Denn es gibt viele in Daten versteckte Zusammenhänge zu entdecken, aus denen man Vorhersagen entwickeln kann. Diese synthetischen Vorhersagesysteme, die aufgrund von vorhandenen Daten lernen, finde ich persönlich am faszinierendsten – das ist mein Traum, der dahinter steht.“

Quelle: https://www.weltderphysik.de/gebiet/technik/computing/neuromorphe-computersysteme/