I-WAY, EDG, EGEE: Etappen des Grid-Computings

Die Wurzeln des Grid-Computings gehen fast soweit zurück wie die Geschichte vernetzter Rechensysteme. Die Entwicklung hat aber insbesondere in den letzten zehn Jahren starken Auftrieb erfahren.

Der Versuch, eine einheitliche Infrastruktur zur verteilten Ressourcennutzung zu schaffen, ist über 10 Jahre alt: 1995 wurden anlässlich der Konferenz Supercomputing ‚95 siebzehn verschiedene Standorte im Rahmen des Projektes I-WAY (Information Wide Area Year) miteinander verbunden. Mit neuen Geldmitteln wurden die dazu erstellten Software-Komponenten dann ab 1996 weiterentwickelt, was als Geburtsstunde der verbreiteten Grid-Software Globus gelten kann.

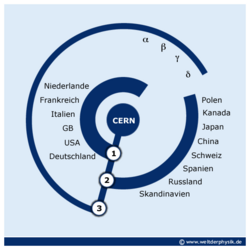

In ähnlichem Zeitraum begannen die Vorarbeiten für den absehbar größten Nutzer des Grid-Computings – den Large Hadron Collider LHC des europäischen Forschungszentrums CERN in Genf. Es war klar, dass das Prozessieren der Daten der Experimente dieses Teilchenbeschleunigers mit der existierenden Rechnerinfrastruktur nicht mehr zu bewältigen sein würde. Im Rahmen der MONARC-Studie (Models of Networked Analysis at Regional Centres for LHC Experiments) wurde eine hierarchische Struktur entworfen, mit einer „Wurzel“ (dem sog. Tier-0 Zentrum) am CERN und Tier-1 Zentren in verschiedenen europäischen Ländern. Diesen untergeordnet sind dann jeweils Tier-2 und Tier-3 Zentren, mit jeweils unterschiedlichen Aufgaben in der Analyse der Daten. Das deutsche Tier-1-Zentrum GridKa ist am Forschungszentrum Karlsruhe im Institut für wissenschaftliches Rechnen beheimatet.

Mit der Veröffentlichung von Ian Fosters und Carl Kesselmanns Buch „Grid Computing: Blueprint for a new Computing Infrastructure“ wurde 1999 dann auch der Name „Grid Computing“ hoffähig und gilt seitdem als Oberbegriff für die hier beschriebenen Entwicklungen. Auch die aus der MONARC-Studie hervorgegangene Infrastruktur verwendet heute diesen Namen – man spricht vom „LHC Computing Grid“ (kurz LCG).

Zu Beginn der Gridbewegung fehlte noch eine passende Middleware, also jene Software, die zwischen den Nutzern und dem System vermittelt. So verstanden sich die Versionen 1 und 2 des Middleware-Pioniers Globus eher als eine Art Werkzeugkasten zur Entwicklung fortgeschrittener Gridtechnologien. Insbesondere musste der Benutzer wissen, welche Zielressourcen er ansprechen wollte. So konnte er seine Programme etwa nur an einen geographisch entfernten Cluster versenden, wenn er dessen Adresse kannte. Die Notwendigkeit zur direkten Interaktion mit dem Zielsystem widerspricht aber dem Gedanken, global verteilte Rechenressourcen gewissermaßen wie einen einzigen, riesigen Computer zu verwenden. Dies setzt ja voraus, dass der Benutzer eben keine Kenntnis über verfügbare Ressourcen haben muss. Globus alleine war als Middleware für LCG also kaum geeignet.

2001 wurde deshalb ein neues EU-Projekt ins Leben gerufen – das European Data Grid (EDG). Es handelte sich dabei in erster Linie um ein Forschungsprojekt, das insbesondere die einfache Nutzung von Grid Ressourcen ermöglichen sollte. Hauptprojekt war damit die gleichnamige Grid Middleware EDG. Als Kernkomponente beinhaltet sie einen „Resource Broker“, dessen Aufgabe es ist, anhand der Bedürfnisse der Nutzerprogramme eine passende Zielressource auszuwählen. Dies vereinfacht die Arbeit mit dem Grid enorm.

EDG bildete, kombiniert mit einigen anderen Softwareprojekten, den Kern des LHC Computing Grids und der gleichnamigen LCG Middleware. Teil der Aufgabe von LCG ist es, bereits vor dem Anlaufen des Beschleunigers im Jahr 2007 die Leistungsfähigkeit der Software- und Hardware-Infrastruktur sicherzustellen. Zu diesem Zweck werden regelmäßig so genannte Data Challenges organisiert, bei denen die beteiligten Zentren über längere Zeiträume hinweg ein Maximum an Daten entgegennehmen und verarbeiten müssen. So werden Probleme der Infrastruktur sehr schnell offenbar.

EDG wurde im März 2004 erfolgreich abgeschlossen. Ziel des im April 2004 angelaufenen Nachfolgeprojektes EGEE (Enabling Grids for E-SciencE, seit April 2006 bereits in der zweiten Projektphase) ist nun nicht mehr in erster Linie die Erforschung neuer Softwaretechnologien, sondern die Etablierung einer schlagkräftigen Organisationsstruktur zur Unterstützung des Grid Betriebs. Hierzu zählen etwa Angebote zum Training und zum Support oder globale und regionale Operationcenter (GOC und ROC). Das deutsche ROC wird hierbei vom Forschungszentrum Karlsruhe aus betreut. Die prototypische EDG Middleware wurde im EGEE-Projekt zu einer produktionsreifen Softwareumgebung mit dem Namen „gLite“ weiterentwickelt. EGEE vollzieht damit den wichtigen Schritt von der Forschung zur Anwendung. Als größtes Grid-Projekt der Europäischen Union hat sich sein ursprünglich auf Europa beschränkter Wirkungskreis auf viele außereuropäische Länder ausgedehnt. Zusammen mit dem eng verwandten LCG betreibt EGEE eine weltweite Rechnerinfrastruktur von über 50.000 CPUs und 5 Petabyte Speicher und es werden täglich mehr als 100.000 Rechenaufträge ausgeführt. Zu den Nutzern zählt neben der Elementarteilchenphysik eine Vielzahl weiterer Forschungsbereiche, mit der Bioinformatik als zweitgrößter Teilnehmergruppe. Auch Industrieunternehmen sind über das Industrieforum direkt an EGEE beteiligt. Die dritte Projektphase wird von 2008-2010 dauern. Im Anschluss daran ist geplant, die weltweit verteilten Produktionsinfrastrukturen nachhaltig in die nationalen Grid-Initiativen zu integrieren. In Deutschland wird diese Aufgabe von D-Grid übernommen werden.

Welt der Physik

Quelle: https://www.weltderphysik.de/gebiet/technik/computing/etappen/